반응형

이 글에서는 LM Studio를 사용해 로컬 환경에서 AI 모델(Llama 3.2 등)을 실행하고, 이를 VS Code의 Continue 확장 프로그램과 연동해 코딩 작업에 도움을 얻는 방법을 단계별로 안내합니다.

1. 준비물

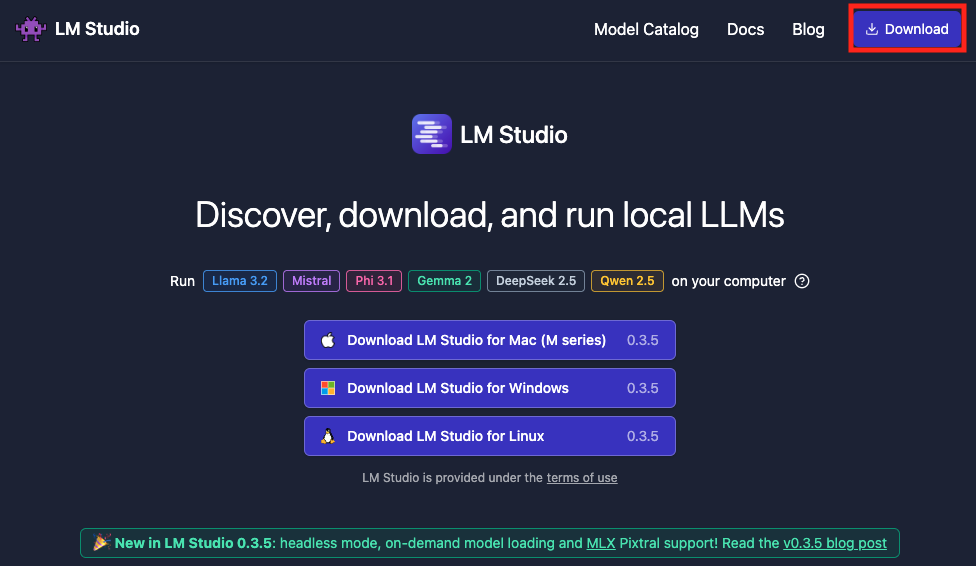

1. LM Studio 설치 파일

- 다운로드: LM Studio 공식 웹사이트

2. AI 모델

- 예: Llama 3.1 (8B/70B 등) Hugging Face나 LM Studio 내에서 설치 가능.

3. VS Code (Visual Studio Code)

- 다운로드: VS Code 공식 웹사이트

4.Continue 확장 프로그램

- VS Code Extensions Marketplace에서 설치 가능.

2. LM Studio 설치 및 설정

2.1 LM Studio 설치

- LM Studio를 다운로드하고 설치합니다.

- 설치 후 실행합니다.

2.2 AI 모델 설치

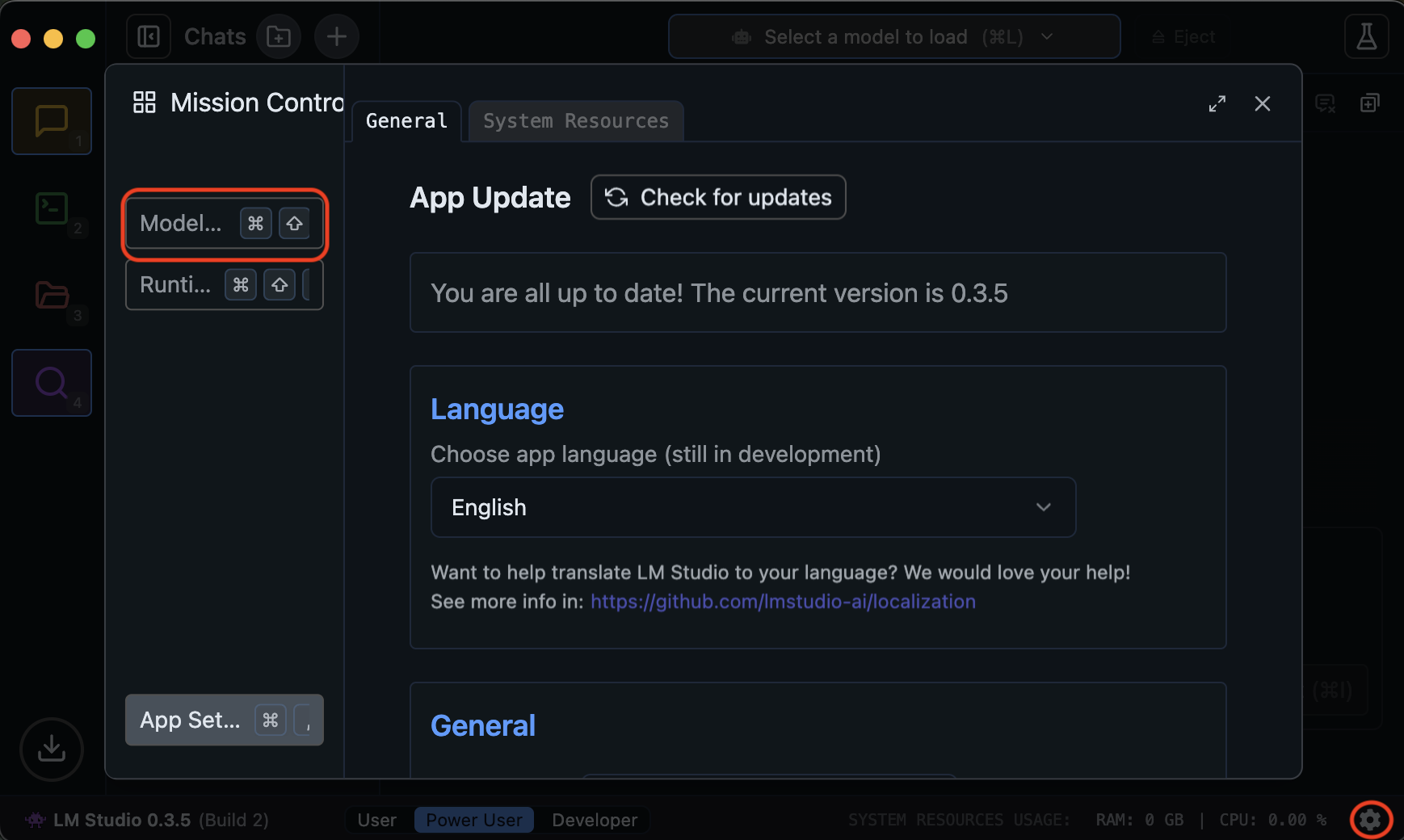

- LM Studio를 실행한 뒤, "설정" 아이콘을 클릭합니다.

- "Model Seach" 클릭합니다.

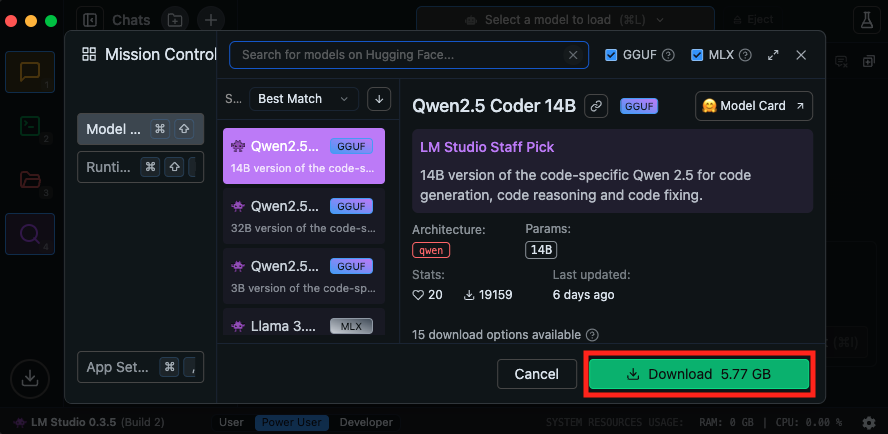

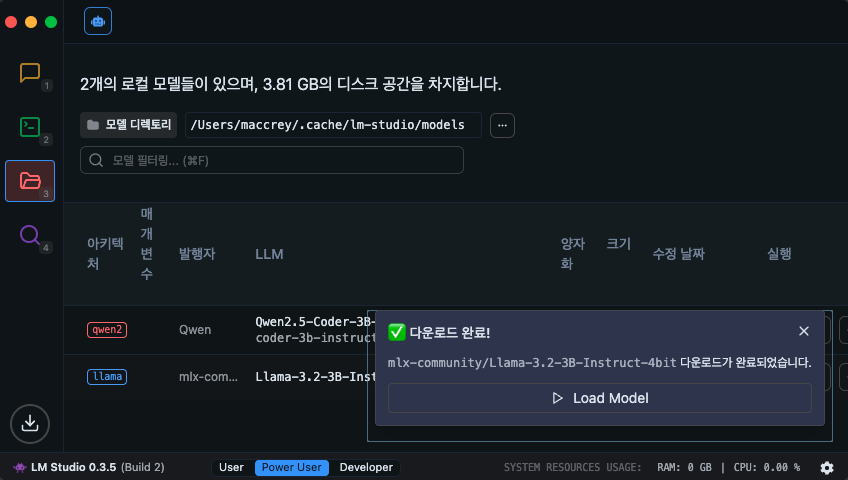

- Llama 3.2 3B Instruct 4bit 와 같은 모델을 선택하거나 원하는 모델 경로를 제공하여 설치합니다.

- Qwen2.5 Coder 3B Istaruct 추천 (코딩에 최적화되어 있는 모델)

- 경량화된 모델(4bit) 사용 가능.

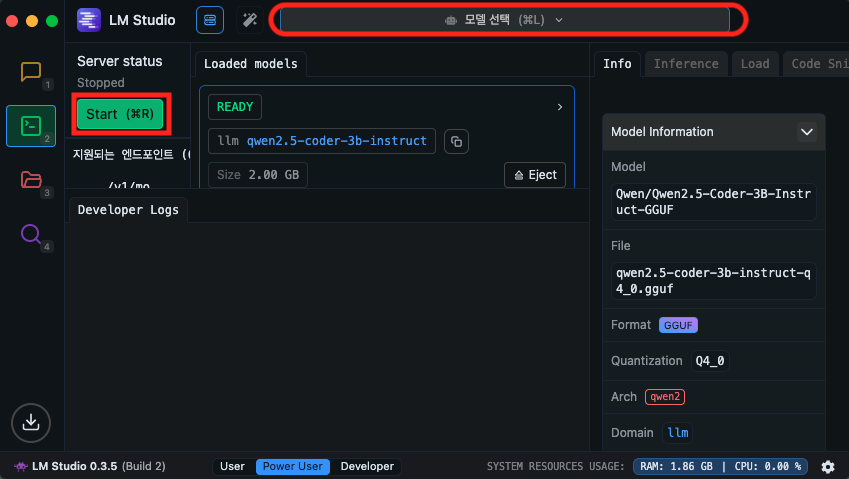

- 모델 설치가 완료되면 선택 후 "Start Server" 버튼을 클릭하여 모델을 실행합니다.

3. VS Code에서 Continue 설치 및 설정

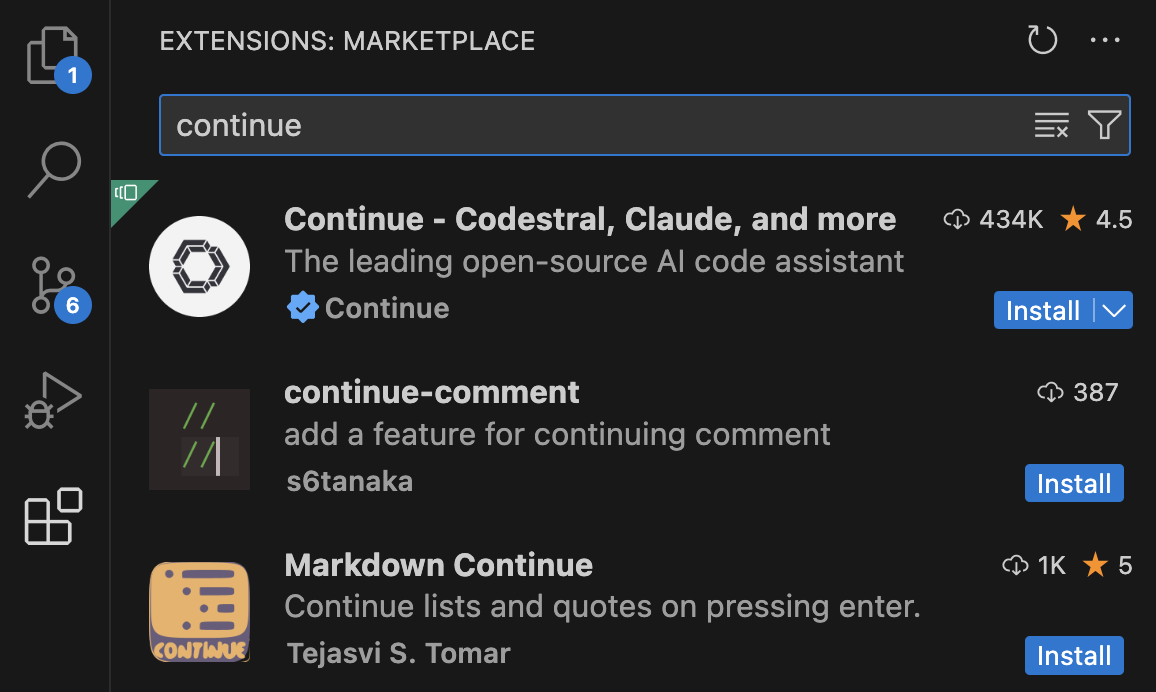

3.1 Continue 확장 프로그램 설치

- VS Code를 열고 좌측 Extensions Marketplace로 이동합니다.

- 검색창에 "Continue"를 입력하고 해당 확장을 설치합니다.

- 설치가 완료되면 좌측 사이드바에 Continue 아이콘이 나타납니다.

3.2 Continue 설정

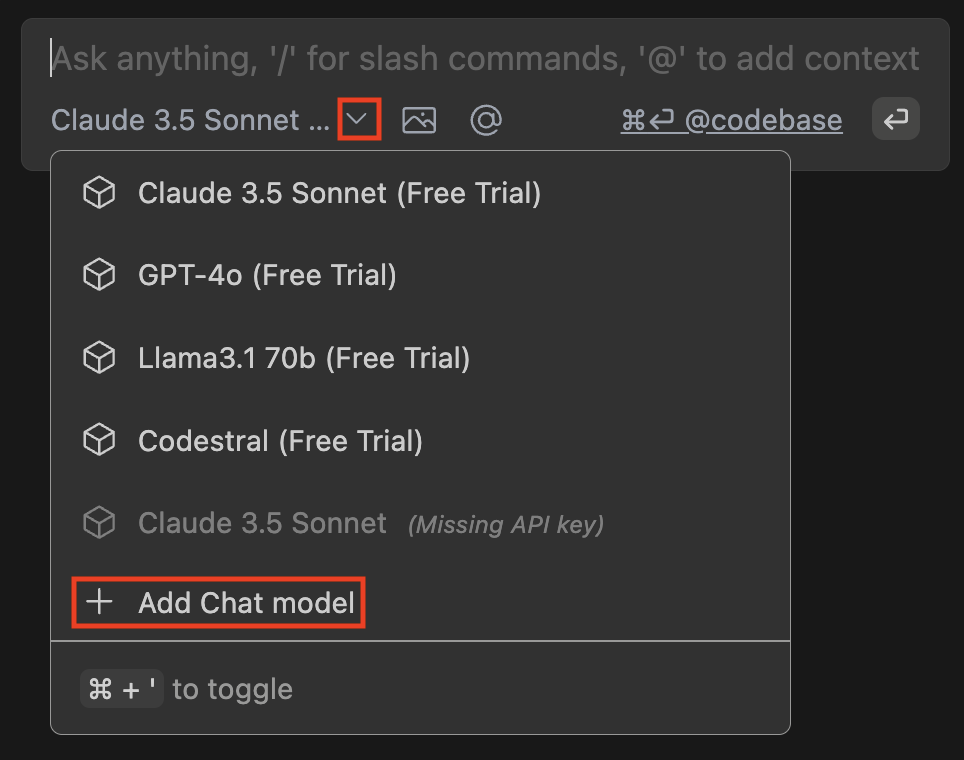

- Continue 아이콘을 클릭하여 설정 화면을 엽니다.

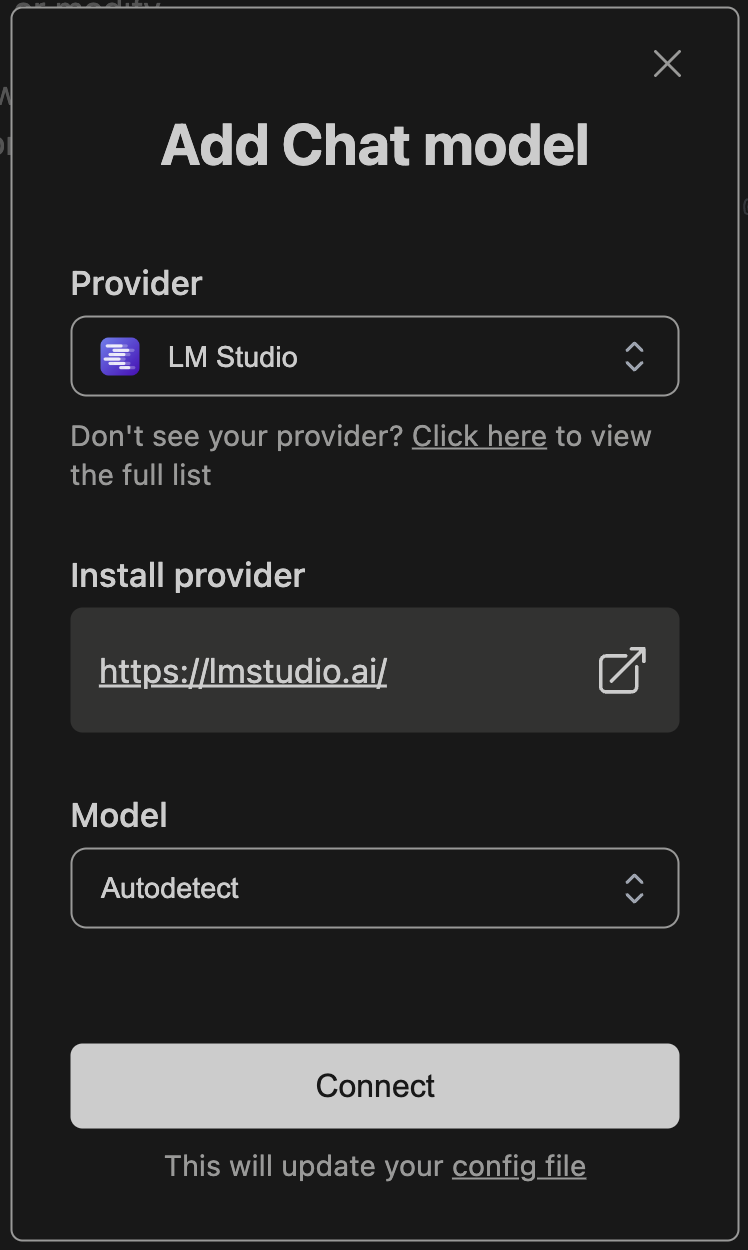

- 모델 선택 버튼을 누르고 "+Add Chat model"을 선택합니다.

- 사진과 같이 셋팅을 합니다.

- 설정을 저장합니다.

4. VS Code에서 AI 사용하기

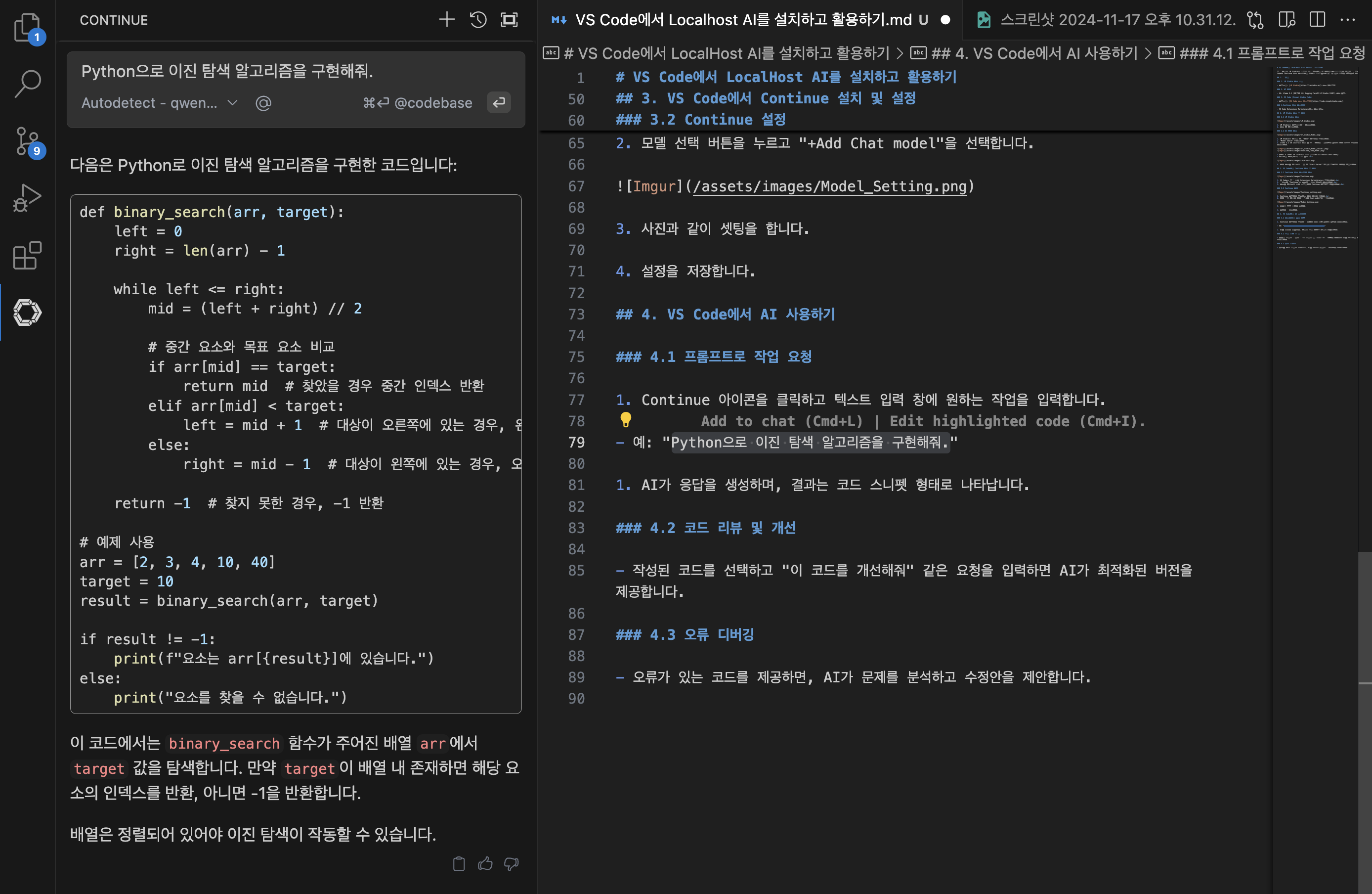

4.1 프롬프트로 작업 요청

- Continue 아이콘을 클릭하고 텍스트 입력 창에 원하는 작업을 입력합니다.

- 예: "Python으로 이진 탐색 알고리즘을 구현해줘."

- AI가 응답을 생성하며, 결과는 코드 스니펫 형태로 나타납니다.

4.2 코드 리뷰 및 개선

- 작성된 코드를 선택하고 "이 코드를 개선해줘" 같은 요청을 입력하면 AI가 최적화된 버전을 제공합니다.

4.3 오류 디버깅

- 오류가 있는 코드를 제공하면, AI가 문제를 분석하고 수정안을 제안합니다.

구독!! 공감과 댓글,

광고 클릭은 저에게 큰 힘이 됩니다.

Starting Google Play App Distribution! "Tester Share" for Recruiting 20 Testers for a Closed Test.

Tester Share [테스터쉐어] - Google Play 앱

Tester Share로 Google Play 앱 등록을 단순화하세요.

play.google.com

반응형

'Development News > AI' 카테고리의 다른 글

| “문서가 찾아갑니다!” 토스 프론트엔드의 혁신적인 문서 활용법 (0) | 2024.11.18 |

|---|---|

| “AI 개발, 이제 자동화로 간편하게!” 앤트로픽, 개발자용 프롬프트 엔지니어링 도구 출시 (0) | 2024.11.18 |

| 고난이도 수학 문제를 풀기 위한 AI 벤치마크 등장: GPT-4o와 클로드도 2%만 해결 (4) | 2024.11.15 |

| 업스테이지, 풀스택 LLM으로 기업 혁신 주도! 멀티모달 아닌 진정한 기업용 AI 솔루션 (1) | 2024.11.15 |

| 구글, 제미나이 2.0 드디어 출시 임박! 오픈AI o1-미니 성능 능가하며 AI 혁신 선두? (0) | 2024.11.15 |